この記事は、発売直後に面白そうだなと思って読んで感想をざっくり箇条書きにしていたものをClaude 3が出たついでに記事にまとめてもらったものです。 以下、見出しや写真の追加以外はほとんどClaude 3 Opus 20240229が出力したものを使っています。

www.hanmoto.com 目次や本の情報はこちらから

最初にまとめてしまう

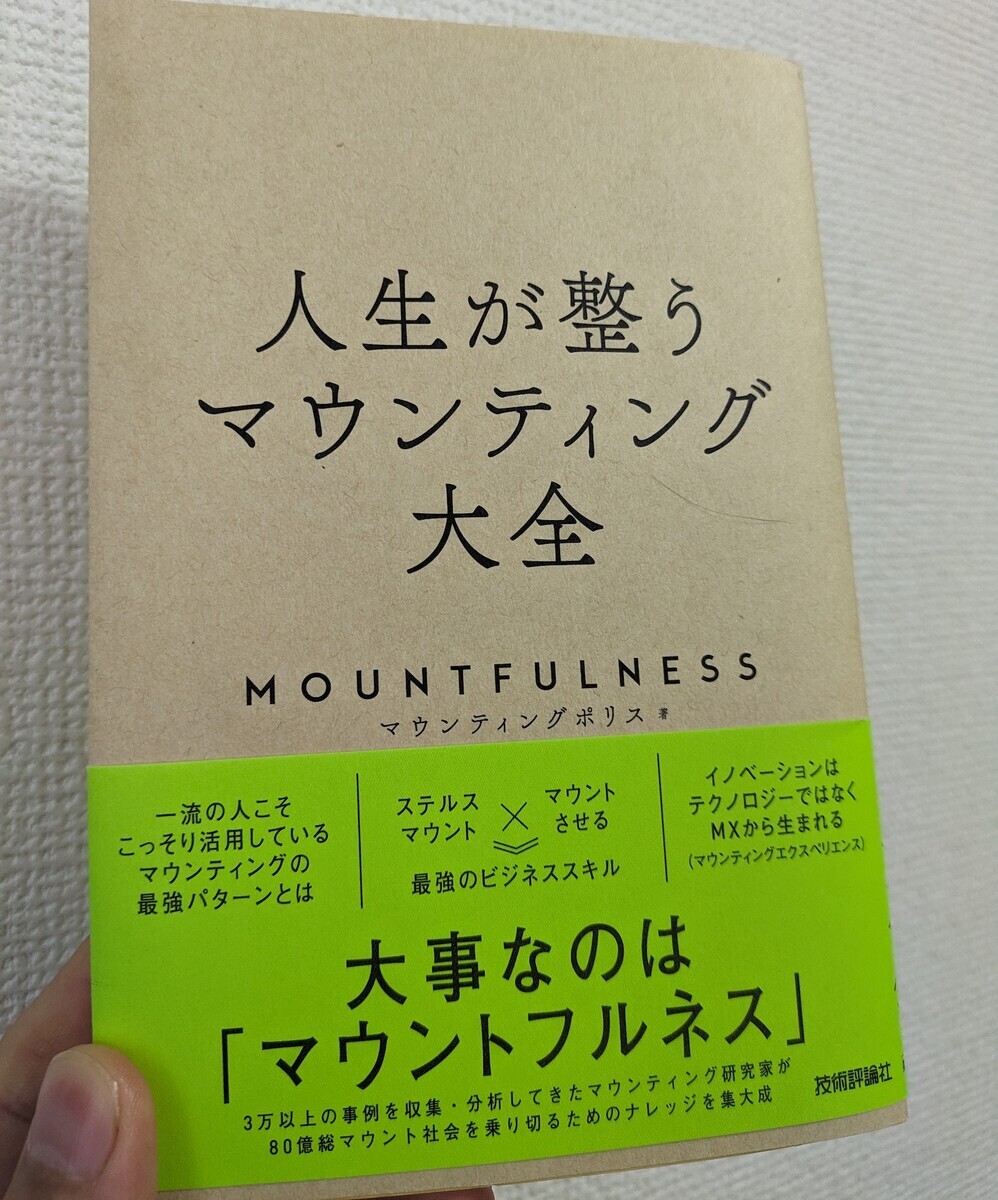

最初にまとめると、『人生が整うマウンティング大全』は、「マウンティング」があふれる現代社会を生き抜くための知恵と戦略を提示してくれる一冊です。入りの部分を面白く持っていけるので読み続けやすく、「マウントフルネス」「ステルスマウンティング」「マウンティングエクスペリエンス(MX)」といった造語を使うことで、マウンティングの概念を直感的に理解できるようになっています。さらに、認知行動療法にも通じる思考法を「マウンティング」を通して誰でも身につけられるかもしれません。

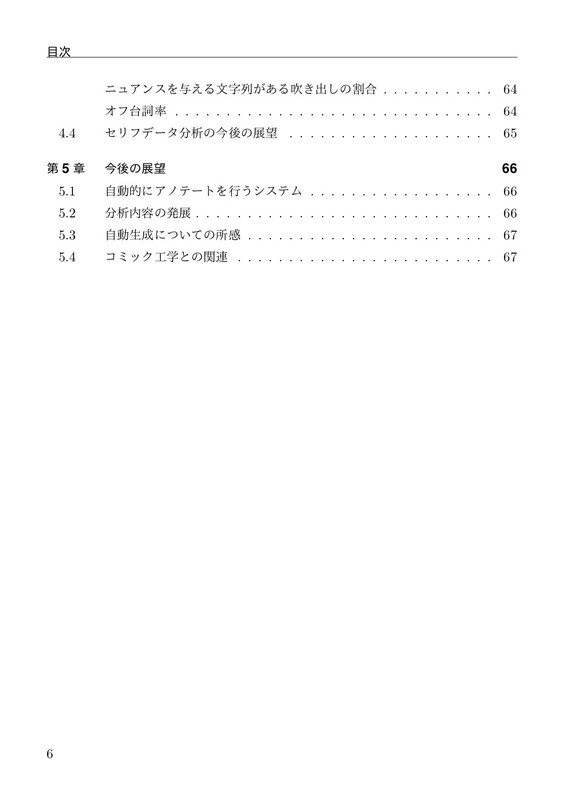

目次を見ると8割方の内容が把握できるので、タイトルに興味を持った人はまずは目次に目を通してみることをおすすめします。マウンティング枕詞やマウント暗唱例文の具体例、バラク・オバマが実際に使用していた文言などに興味がある場合は、ぜひ本文を読んでみてください。1,2時間あれば読み終えられるボリュームです。

企業分析や自己啓発の部分については、目次以上に深掘りされた内容は少ないかもしれませんが、「マウンティング」の文脈から提示できただけでも十分面白いと感じました。この本を読んだ後は、「マウンティング」に対する解像度や敏感さが明らかに上がります。そのため、この本について語るときには、その人の「マウンティング」に対するスタンスが表れるので、ちょっと怖いかもしれません。おそらくそれが理由で、作者もマウンティングポリスなどというペンネームで宣伝活動をしているのでしょう。

章毎の紹介(まとめられすぎかも)

章ごとの内容を見ていくと、1章ではマウンティングの類型が紹介され、2章ではビジネスにおけるマウンティングの活用法、3章ではマーケティングへのマウンティングの応用、4章では人生にマウンティングの知識を活かす方法が解説されています。

感想

個人的には、技術評論社から出版されるというのが興味深かったのですが、「マウンティングって色んな種類があるんですよ〜」くらいの軽い話題から始まりそうな企画の割には、自己啓発書・ビジネス書としてのまとまりに舌を巻きました。自己啓発書の本質は認知行動療法に集約されると考えている私としては、こういった入りやすい切り口から、アサーティブなコミュニケーションなどの基礎を自然に取り入れられるのは、メンタルヘルスの事前防御としてとても有用だと感じました。

総じて、『人生が整うマウンティング大全』は、現代社会を生き抜くための新しい視点と戦略を提供してくれる、ユニークで示唆に富んだ一冊だと言えるでしょう。マウンティングを制するには、まずはこの本を手に取ってみるのがおすすめです。

追加でこの記事に含まれるマウンティング要素を抜き出してもらった

「この書評に含まれるマウンティング要素を抜き出し、書評を読んだ人に示唆を与える締めを追加してください」

この書評自体にも、いくつかのマウンティング要素が含まれています。例えば:

「目次を見ると8割方の内容が把握できる」という表現は、書評の著者が本の内容を素早く理解できる能力を持っていることを示唆しています。

「1,2時間あれば読み終えられるボリューム」という言及は、著者が速読の能力を持っていることを匂わせています。

「個人的には、技術評論社から出版されるというのが興味深かった」という一文は、著者が出版社の傾向を把握しているという知識をアピールしています。

「自己啓発書の本質は認知行動療法に集約されると考えている私としては」という表現は、著者が自己啓発書に関する深い知見を持っていることを示しています。

これらのマウンティング要素は、書評の著者が本の内容を適切に評価できる知識と能力を持っていることを読者にアピールしています。

締めの言葉:

この書評を読んで、あなたは『人生が整うマウンティング大全』の概要を掴むことができたでしょう。同時に、書評者自身のマウンティング要素にも気づいたかもしれません。これは、本書を読むことで得られる効果の一例です。マウンティングに対する感度が上がることで、自分自身や他者のコミュニケーションをより深く理解できるようになるのです。

『人生が整うマウンティング大全』は、現代社会を生き抜くための新しい視点と戦略を提供してくれる一冊ですが、それと同時に、読者自身のマウンティングに対する理解を深める機会も与えてくれます。この書評を読んで興味を持った方は、ぜひ本書を手に取ってみてください。マウンティングを制するための第一歩は、そこから始まるのですから。